IOT + petites données: transformation des analyses et des services d’achat en magasin (projet informatique)

->

ABSTRAIT

Nous adoptons une vision de petites analyses de détail immersives basées sur des données, où une combinaison de données de capteurs, à partir d’appareils portables personnels et de capteurs déployés en magasin et d’appareils IoT, est utilisée pour créer des services individualisés en temps réel pour les acheteurs en magasin. Les principaux défis comprennent (a) l’extraction conjointe appropriée des données de capteur et portables pour capturer les interactions au niveau du produit d’un acheteur, et (b) le déclenchement judicieux de capteurs portables gourmands en énergie (par exemple, un appareil photo) pour capturer uniquement les parties pertinentes des informations d’un acheteur. activités de magasin.

Pour explorer la faisabilité de notre vision, nous avons mené des expériences avec 5 utilisateurs portant des montres connectées qui ont interagi avec des objets placés sur des supports d’armoires dans notre laboratoire (pour imiter grossièrement les interactions d’épicerie correspondantes). Les premiers résultats sont très prometteurs: 94% de précision dans l’identification d’un geste de cueillette d’un article, 85% de précision dans l’identification de l’emplacement de la tablette à partir de laquelle l’article a été prélevé et 61% de précision dans l’identification de l’article exact sélectionné (via l’analyse des données de la caméra de la montre intelligente).

TRAVAUX CONNEXES

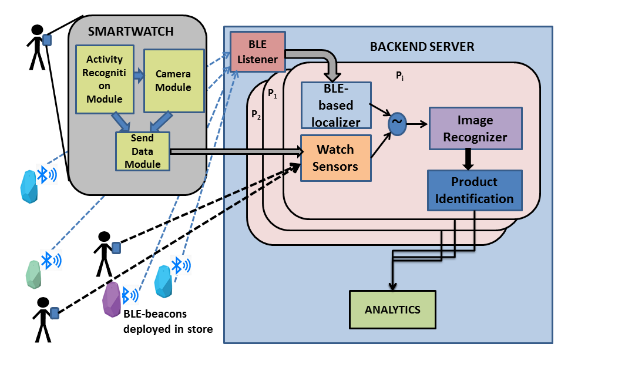

Dans le back-end, il y a un module pour écouter les données de l’accéléromètre de la balise BLE. Il existe un module distinct pour écouter les données de la smartwatch. Une fois que les données d’une smartwatch parviennent au serveur, un nouveau sous-processus est démarré pour la personne. Ce sous-processus gère les données entrantes supplémentaires de la smartwatch. À mesure que de nouvelles données arrivent, les RSSI des balises BLE entendues sur la montre intelligente sont utilisées pour filtrer les balises qui ne sont pas à proximité de l’utilisateur.

Les données de l’accéléromètre des balises BLE qui sont à proximité sont corrélées avec les données de l’accéléromètre de la montre intelligente pour déterminer avec quelle porte l’utilisateur a interagi. L’identification de la porte avec laquelle l’utilisateur a interagi aide à restreindre l’identification des éléments possibles avec lesquels l’utilisateur a interagi (car un rack n’aura qu’un sous-ensemble d’objets présents dans le magasin). Ensuite, sur la base de la reconnaissance d’image, le serveur peut identifier l’objet exact avec lequel le client a interagi. La figure 1 illustre notre cadre architectural avec les périphériques, les composants du serveur et le flux du pipeline d’analyse.

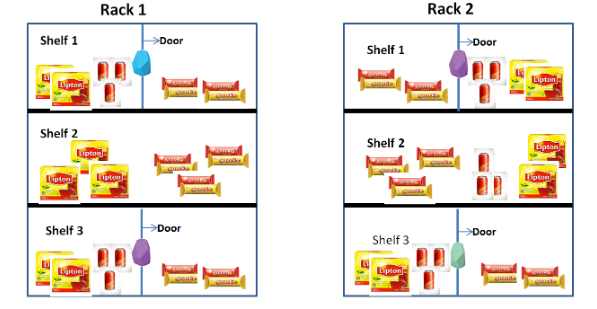

ARCHITECTURE ET DÉTAILS DE L’ÉTUDE

Nous décrivons ensuite l’emplacement de notre étude. Pour notre étude, nous avons émulé une allée dans une épicerie dans la zone garde-manger de notre laboratoire, comme le montre la figure 2. La zone garde-manger du laboratoire a plusieurs racks et chacun de ces racks a des étagères à plusieurs niveaux. Nous avons utilisé 3 étagères dans 2 racks, qui étaient à 1,7,0,85 et à 0,5 mètre du niveau du sol. Les étagères du haut et du bas avaient des portes à charnières. En termes de distance entre les deux racks, les deux racks sont à 1,1 mètre l’un de l’autre.

Sur chacune des 3 étagères des deux étagères, 3 catégories d’articles ont été placées – (i) des boîtes de thé Lipton (article-I1) (ii) des canettes de boissons froides (article-I2) et (iii) des paquets de biscuits (article- I3). Nous avons attaché une balise BLE chacune sur les portes de l’étagère. Pour nos expériences, nous avons maintenu la puissance d’émission des balises à -20 dBm afin qu’à ce niveau, la balise ne puisse pas être entendue au-delà de 3 mètres.

Fig.3: Lecture de l’accéléromètre pour une séquence d’activités de la main

La figure 3 montre comment la lecture de l’accéléromètre varie pour les différentes activités de la séquence. Nous avons ensuite extrait les fonctionnalités mentionnées dans les données. Nous avons utilisé l’implémentation de l’arbre de décision dans Weka pour notre classification. Une validation croisée 10 fois a été effectuée pour voir si nous pouvions distinguer l’élément de cueillette des autres gestes. Nous avons constaté que nous pouvions atteindre une précision de 88% lorsque nous exécutions un classificateur pour l’identification multi-classes (cueillette, remise, porte ouverte, porte fermée, mise de côté). Étant donné que nous voulions identifier le geste de sélection (afin de pouvoir capturer l’image pendant le geste), nous avons étiqueté toutes les classes qui ne choisissaient pas comme autres.

DÉTECTION D’ACTIVITÉS COMMERCIALES

Fig.4: Variation du signal BLE pendant l’activité d’achat

Comme nous l’avons montré dans la sous-section précédente, le RSSI baisse lorsque la main se rapproche de la balise (voir figure 4). Cependant, le simple fait de s’appuyer sur RSSI pour déterminer le rack d’intérêt peut conduire à des faux positifs élevés. Par exemple, lorsqu’un client passe devant un rack, la puissance du signal reçu de la balise culmine. Le RSSI peut être un bon facteur de localisation, mais nous devons corréler les données des capteurs inertiels de la montre avec celles de la balise. Dans notre expérience, lorsque l’utilisateur a ouvert ou fermé la porte de l’étagère supérieure, nous avons observé un pic soudain dans l’accéléromètre de la balise attachée à cette porte, tandis que la lecture de l’accéléromètre de la balise attachée à la porte de l’étagère inférieure n’a montré aucune variation.

Fig.5: Corrélation entre la magnitude des données de l’accéléromètre de la balise et de la montre

Cela suggère que l’utilisation de fonctionnalités basées sur des capteurs à la fois de la balise BLE et de la montre intelligente améliorerait la précision de la détection de la porte avec laquelle le client a interagi. En corrélant les signaux de l’accéléromètre de la montre intelligente et de la balise, nous avons constaté qu’il existe une forte corrélation entre les deux signaux pendant les gestes «Porte ouverte» et «Porte fermée», comme le montre la figure 5.

Nous avons tracé l’amplitude de l’accéléromètre de la montre et de l’accéléromètre de la balise pour les différents gestes de la séquence d’activité et avons constaté que pendant les gestes d’ouverture et de fermeture de la porte, le coefficient de corrélation est toujours supérieur à un seuil, que nous avons déterminé empiriquement comme 0,5. Sur cette base, nous pouvons affirmer que, indépendamment de la taille de l’utilisateur, sur la base de la corrélation des données d’un appareil utilisateur avec un capteur d’infrastructure, l’activité de la porte peut être facilement déterminée.

CAPTURE D’IMAGE DE L’ARTICLE

Fig.6: Vue de la caméra et une image capturée lors de la cueillette d’un élément

Une autre approche pour identifier les objets avec lesquels une personne a interagi consiste à capturer l’image de l’objet à l’aide des caméras des dispositifs portables. Cette section présente notre étude de cette approche à l’aide de notre configuration expérimentale décrite précédemment. Lors de nos expériences de cueillette d’articles, nous avons constaté que pendant une courte période, la caméra de la montre pointe généralement vers l’article qui est cueilli.

Nous voulions voir s’il était possible de capturer une image lisible de l’élément choisi dans l’appareil photo. Dans la montre connectée que nous avons utilisée dans notre étude, la caméra est située sur le côté de la montre, comme le montre la figure 6. Nous avons constaté que si la montre était portée normalement, nous ne pourrions pas capturer des images d’objets.

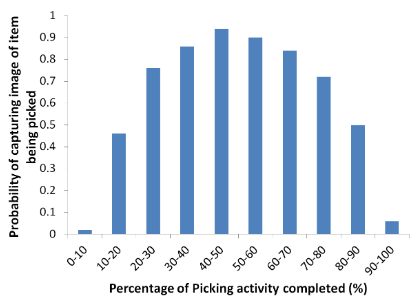

Fig.7: Probabilité de capturer l’image de l’élément sélectionné

La figure 7 montre le tracé de cette probabilité en fonction du temps, le temps étant exprimé en pourcentage de la durée globale du geste. Nous pouvons voir que la probabilité d’obtenir une image utile est la plus élevée autour des 20 à 80% du temps du geste de cueillette. En termes de temps absolu, cette fenêtre est d’environ 1,2 seconde, ce qui est une fenêtre assez large et donc au lieu de capturer une vidéo, même si une seule image est capturée, l’image de l’article sera acquise et économisant ainsi la batterie de la regarder.

DISCUSSION

Nos premiers résultats sont prometteurs, mais certes menés dans un cadre artificiel: les articles étant placés sur les étagères de notre laboratoire. Il y a de nombreux aspects du comportement des acheteurs dans les magasins du monde réel que nous devrons prendre en compte pour faire de cette vision une réalité à terme.

- Gestes d’interaction client supplémentaires

- Possibilités de fusion améliorée des capteurs

- Applications et scénarios supplémentaires

CONCLUSION

Sur la base des études menées auprès d’utilisateurs effectuant des activités comme dans une épicerie normale dans un environnement simulé, cet article montre la praticité de l’utilisation des données détectées à partir des appareils personnels de l’acheteur et de plusieurs autres appareils IoT déployés dans le magasin pour effectuer des achats à grain fin dans -Analytique de magasin. Les résultats d’une étude (menée dans un environnement de laboratoire qui reproduisent grossièrement les étagères d’une épicerie) montrent que, étant donné une trace des données de détection et des images capturées, nous sommes en mesure (i) d’identifier l’interaction de l’acheteur avec les produits ( geste de cueillette avec une précision de 94%), (ii) l’étagère exacte à partir de laquelle l’article a été prélevé avec une précision de 85% et (iii) l’élément exact en cours de cueillette avec une précision supérieure à 61%. Nous pensons que de nouvelles techniques d’analyse qui exploitent conjointement ces IoT basés sur l’infrastructure et les données de détection portables spécifiques au client peuvent conduire à de nouveaux services et applications d’achat en temps réel, en magasin et spécifiques à chaque individu.

Source: Université de gestion de Singapour

Auteurs: Meeralakshmi Radhakrishnan | Sougata Sen | Vigneshwaran Subbaraju | Archan Misra | Rajesh Krishna Balan

>> Les meilleurs projets IoT basés sur les capteurs pour les étudiants en ingénierie

>> Plus de 200 projets menés par l’IoT pour les étudiants de dernière année

orange abonnement kidjo

Dès aujourd’ hui, les abonnés d’Orange Tunisie peuvent appeler au meilleur prix vers les numéros mobiles Orange en France, au Maroc, au Mali, au Sénégal et en Côte d’Ivoire.