Configurations expérimentales à faible coût pour la reconstruction 3D en vol (projet électronique)

->

ABSTRAIT

La reconstruction de l’environnement physique à l’aide d’un capteur de profondeur implique des calculs gourmands en données qui sont difficiles à mettre en œuvre sur des systèmes mobiles (par exemple, le suivi et l’alignement de la position du capteur avec les cartes de profondeur). Dans ce papier, nous présentons deux configurations expérimentales pratiques pour numériser et reconstruire des objets réels en utilisant des composants embarqués à bas prix et prêts à l’emploi et des bibliothèques open-source. En guise de cas de test, nous numérisons et reconstruisons une statue de 23 m de haut à l’aide d’un octocoptère sans utiliser de matériel externe.

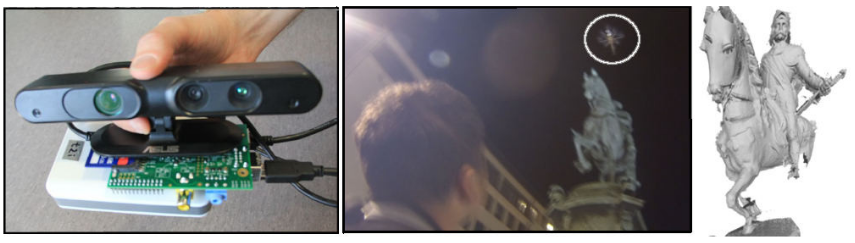

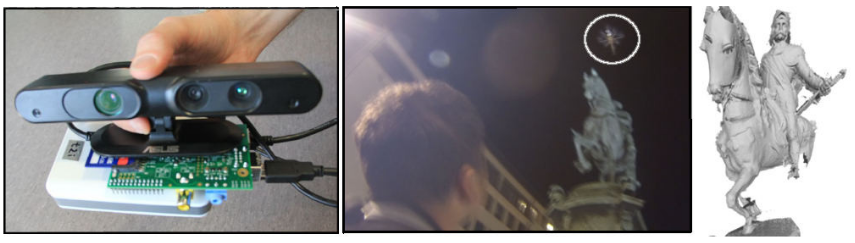

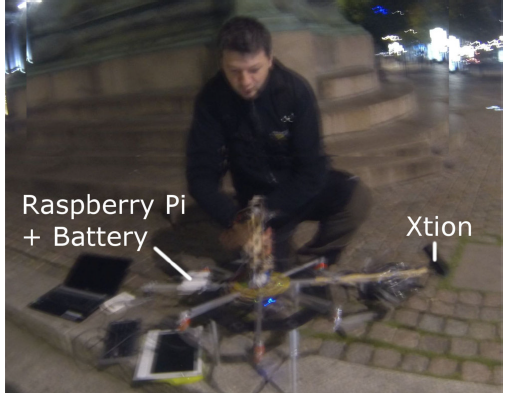

Figure 1: Reconstruction d’une statue à l’aide d’un multicopter: (à gauche) capteur de profondeur portable ASUS Xtion – Raspberry Pi – système de batterie; (milieu) multicopter télécommandé lors de l’enregistrement des cartes de profondeur; (à droite) modèle 3D reconstitué de la statue.

TRAVAUX CONNEXES

Nous passons en revue les applications de reconstruction en temps réel effectuées au sol à l’intérieur ou à l’extérieur, et les recherches utilisant des multicoptères où SLAM est utilisé dans la navigation et la cartographie de l’environnement.

Les capteurs de profondeur à faible coût prennent en charge de nouveaux types d’applications basées sur la reconstruction en temps réel de l’environnement physique. Google Tango [tan] tente de donner aux appareils mobiles une compréhension de l’espace et du mouvement en intégrant des capteurs de profondeur et en les combinant avec les données d’accéléromètre et de gyroscope des téléphones mobiles. Chow et. al propose un système de cartographie mobile pour les environnements intérieurs qui intègre IMU, des cartes de profondeur de deux Kinect et des images de distance d’un système LiDAR.

EXPÉRIENCES

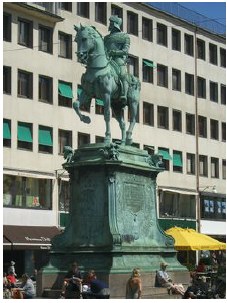

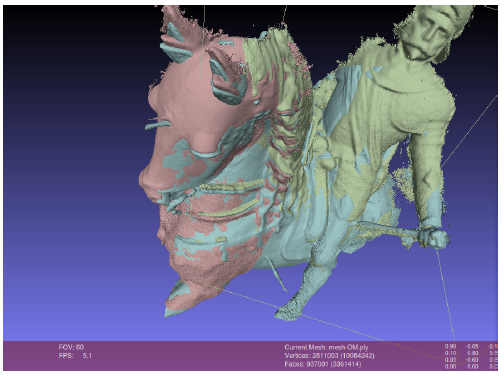

Figure 2: La statue numérisée.

Nous présentons deux configurations pour la reconstruction en vol pour obtenir des images de distance à partir de capteurs de profondeur à l’aide d’un octocoptère. Les deux configurations sont basées sur des composants matériels prêts à l’emploi et des logiciels open source. Comme cas de test, nous avons reconstitué une sculpture de 23,3 mètres de haut et, à ce titre, il est impossible de scanner sans appareil aérien (Fig. 2).

Figure 3: Composants du système de reconstruction en vol.

Le cadre de l’octocoptère a été construit à partir de tiges d’aluminium montées en forme d’étoile. Aux extrémités des huit tiges, les moteurs sans balais Turnigy 2216 ont été montés. Le contrôleur de vol était Mikrokopter [mks]. La batterie Lithium Polymer 4s de 14,8V et 5A a pris en charge un temps de vol de 10 minutes. Deux batteries ont été utilisées. Une tige a été étendue et le Xtion a été monté dessus. Pour l’équilibre, sur la tige opposée, une batterie 5V connectée au RPi de la figure 3 a été montée.

Figure 4: Une capture d’écran de Meshlab pendant l’alignement manuel du maillage.

Les maillages obtenus à l’étape précédente ont été alignés et visualisés dans Meshlab (Fig.4). Ce processus manuel a pris plusieurs heures et était principalement dû à la perte de suivi de la caméra et au volume de reconstruction limité de Kinect Fusion.

Figure 5: Carte Jetson connectée au capteur de profondeur ASUS Xtion sur une batterie.

Dans la deuxième expérience, nous avons testé les capacités de la carte NVIDIA Jetson K1 pour la reconstruction en temps réel. Nous n’avons pas encore monté ce système sur un multicoptère car les performances de reconstruction doivent être améliorées. Nous présentons ici nos résultats prometteurs actuels sur cette plateforme.

Le Jetson K1 est une plate-forme mobile parallèle qui a récemment été publiée par Nvidia pour des applications embarquées telles que la vision par ordinateur, la robotique et l’automobile. [Teg]. Il fournit 326 GFlops à faible coût (192 $) et à faible consommation d’énergie (10w). Le Jetson TK1 est alimenté par Tegra K1, qui établit actuellement le record de performances des puces système embarquées. la configuration matérielle est représentée sur la figure 5.

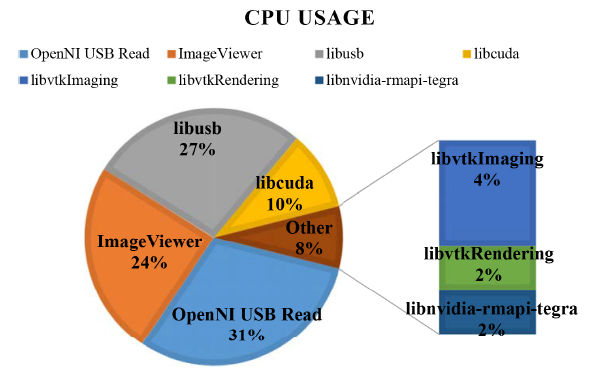

Figure 6: Appels de bibliothèque de l’expérience 2 et leur utilisation du processeur.

Cette fréquence d’images n’a pas été jugée suffisante pour tenter la reconstruction sur le multicopter, nous avons donc commencé à analyser les goulots d’étranglement avec NVIDIA System Profiler. La figure 6 montre les appels de bibliothèque responsables de l’utilisation la plus élevée du processeur ainsi que le pourcentage relatif de charge du processeur dans une seule trame.

DISCUSSION ET TRAVAUX FUTURS

Nous avons présenté deux montages expérimentaux pour obtenir la géométrie d’une statue qui ne permet pas un balayage direct depuis le sol. La première expérience a utilisé la plate-forme Raspberry Pi largement disponible. Le processus de reconstruction et les résultats ont montré la nécessité de visualiser et de traiter les cartes de profondeur en temps réel.

Concernant RQ1, et sur la base des connaissances de notre première configuration, nous avons développé la configuration matérielle en utilisant le Jetson K1 qui permet la reconstruction 3D en temps réel sur le multicopter. Cela a permis l’analyse en ligne de l’état actuel du maillage reconstruit, permettant sa correction et son nouveau balayage si nécessaire. Dans cette deuxième expérience, nous montrons qu’une reconstruction presque en temps réel est réalisable, mais des performances plus rapides sont souhaitables et plus d’optimisation est nécessaire. De plus, cette configuration a posé de nouvelles questions de recherche, telles que:

- Quelle est la bonne voie pour déplacer le capteur de l’Université de technologie de Chaumers?

- Quelle interface et quelle visualisation permettraient à l’utilisateur d’avoir une compréhension complète de ce qui a été scanné?

- comment le chemin du scan doit-il être modifié pour que l’utilisateur puisse corriger le scan?

Concernant RQ2, nous avons constaté que la reconstruction et la visualisation en temps réel sont nécessaires pour reconstruire complètement et obtenir un maillage de qualité de l’objet réel. Contrôler la trajectoire de vol de l’octocoptère et vérifier l’état de la reconstruction est un défi, mais pourrait être résolu grâce à un écran qui se trouve en permanence dans le champ de vision de l’utilisateur qui contrôle l’octocoptère.

Source: Université de technologie Chalmers

Auteurs: Alexandru Dancu | Marco Fratarcangeli | Mickaël Fourgeaud | Zlatko Franjcic | Daniel Chindea | Morten Fjeld